随着深度学习技术的不断深化和发展,对社会生产生活各领域都产生了极为深远的影响。然而,深度学习需要运用到大量数据,对个人隐私产生了重大威胁。研究表明,当仅公开深度学习模型而不公开训练数据时,敌手仍可能通过分析模型参数来获取原始数据信息。例如,可以通过分析模型参数还原部分训练数据或者推断训练集的成员信息。

差分隐私技术是目前最重要的数据隐私保护方法,已成为隐私保护事实上的标准。在深度学习中,主流的隐私保护方法是使用差分隐私保护的随机梯度下降方法(DPSGD)。DPSGD方法自2016年在计算机安全顶会ACM CCS上提出以后,受到研究者广泛关注。如何在满足相同差分隐私的情况下,进一步提高DPSGD效用成为一个极具挑战性的问题。虽然,近年来在ACM CCS、NIPS、SIGKDD、IEEE INFOCOM等计算机顶会上陆续有研究者对DPSGD进行改进,但绝大多数集中于数据采样、数据裁剪、噪声自适应等方面,并未涉及主体算法流程改进方面。

beat365手机中文官方网站陈志立教授课题组发现,DPSGD中的随机采样和高斯噪声会导致梯度偏置和偏差现象,特别在训练过程接近收敛时尤为突出。据此发现,课题组首次引入选择更新和发布的全新思想,对DPSGD主体算法流程进行革新:在数据加噪过程中选择有利更新,提高模型效用和加快模型收敛;通过提出噪声分布截断技术,选择噪声发布,节约隐私预算消耗。课题组从理论上证明新方法严格满足差分隐私,从实验上验证了其性能比已有最先进的方法有了显著的提升。

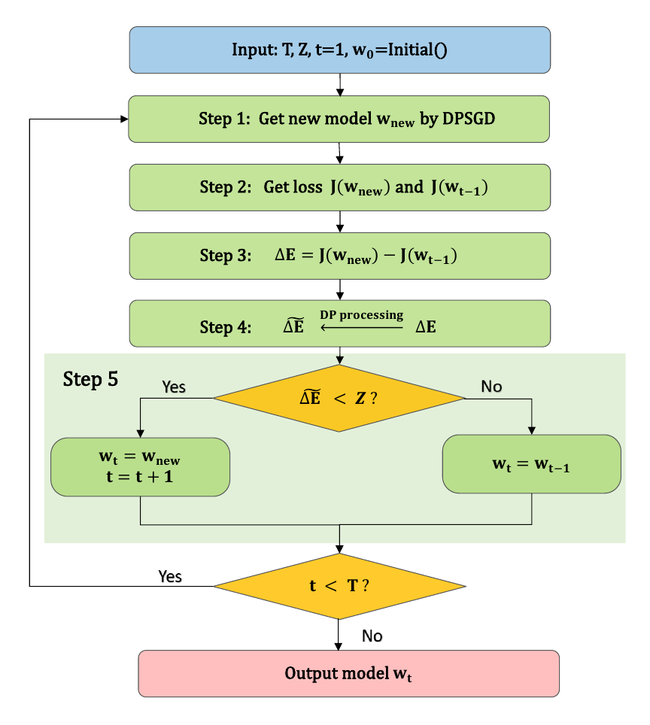

DPSUR算法流程图

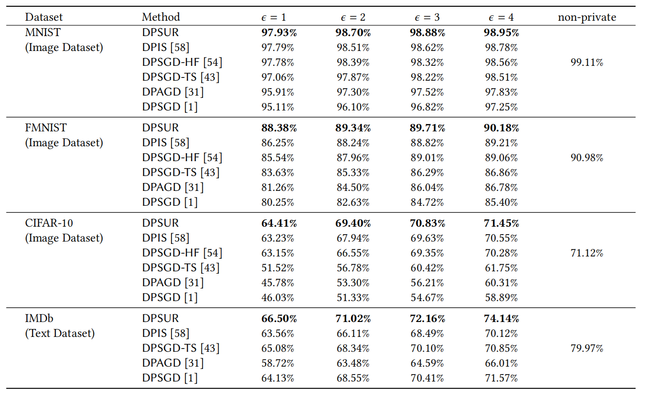

陈志立课题组所提出的基于选择更新和发布的差分隐私保护随机梯度下降训练框架(DPSUR)步骤如下:首先,该方法使用当前迭代与上一次迭代的损失函数差值作为接受或拒绝更新模型参数的标准,使得DPSUR只有在梯度方向正确时才会执行差分隐私梯度下降,确保梯度方向朝着优化目标,从而得到性能更好的模型。其次,提出选择发布的高斯机制,在多次迭代过程中选择性地发布梯度,减少隐私预算消耗。在四个公共数据集MNIST、FMNIST、CIFAR-10和IMDB数据集上进行的实验表明,DPSUR在收敛速度和模型性能方面明显优于之前的研究成果,其准确率逼近甚至达到无隐私保护情况下的数值。

DPSUR的准确率与现有先进的方法比较

该项研究的第一作者和通信作者单位均为华东师范大学。beat365手机中文官方网站2021级硕士研究生符捷为第一作者,其硕士导师陈志立教授为通讯作者,香港理工大学为合作单位。目前,该成果的相应论文DPSUR: Accelerating Differentially Private Stochastic Gradient Descent Using Selective Update and Release (Jie Fu, Qingqing Ye, Haibo Hu, Zhili Chen, Lulu Wang, Kuncan Wang, Ran Xun)已被数据库领域顶级会议50th International Conference on Very Large Databases(VLDB 2024)接收。文章预印版(Arxiv)链接:https://arxiv.org/abs/2311.14056。

近年来,陈志立教授课题组致力于机器学习隐私安全方面的研究,在差分隐私、安全多方计算、联邦学习等领域取得一系列研究成果。

内容来源于课题组

编辑丨俞思远

审核丨曹桂涛